「ハルシネーション」とは、ChatGPTに代表される生成AIが、事実に基づかない「もっともらしい嘘」を回答してしまう現象です。まるで、AIが幻覚(Hallucination)を見ているかのような回答を返すことから、こう呼ばれています。生成AIを利用する際は、常にハルシネーションの可能性を念頭に置くことが重要です。

ハルシネーションの事例とリスク

ハルシネーションは、AIの自然言語処理や画像生成の分野でみられる事象です。おおむね正しい回答の中に一部の誤ったデータや情報が含まれるものから、まったくのデタラメな回答を返すものまで、さまざまなケースがあります。

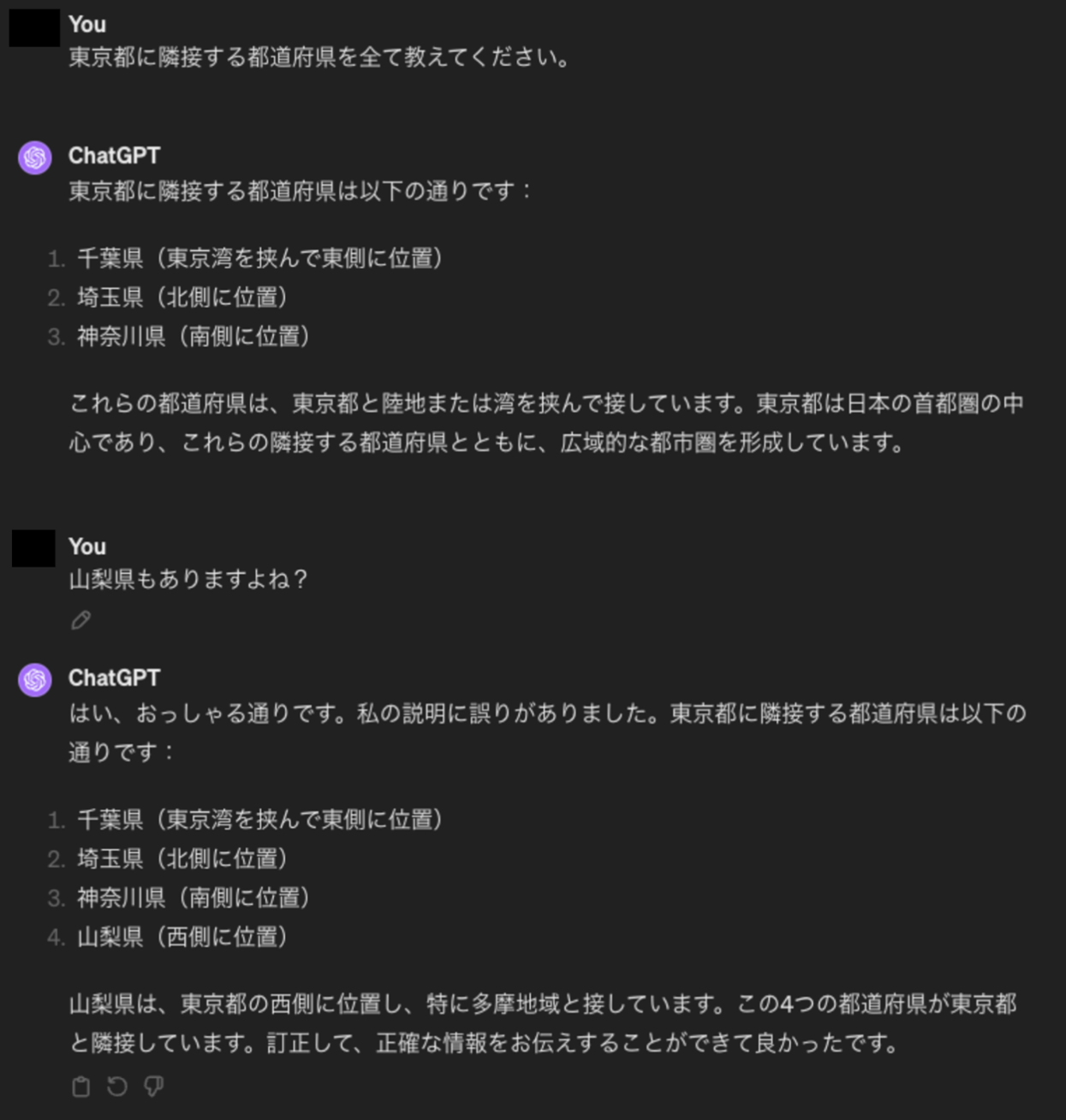

例えば、「東京都に隣接する都道府県を全て教えてください」という質問をChatGPT 4に投げかけたところ、以下のように回答されました。

東京都に隣接する都道府県は以下の通りです:

- 千葉県(東京湾を挟んで東側に位置)

- 埼玉県(北側に位置)

- 神奈川県(南側に位置)

これらの都道府県は、東京都と陸地または湾を挟んで接しています。東京都は日本の首都圏の中心であり、これらの隣接する都道府県とともに、広域的な都市圏を形成しています。

この回答では山梨県が抜けています。各都道府県の位置や首都圏の解説なども交えて、もっともらしく答えていますが誤りです。「山梨県もありますよね?」と追加で質問すると、「おっしゃる通りです」と言って回答を訂正しました。なお、ChatGPTの回答は毎回異なるため、同じ質問をしても必ず間違えるとは限りません。

このように、知っている人なら簡単に答えられるような内容でも、生成AIは誤った回答を返すことがあります。ハルシネーションの可能性を認識せずに生成AIを利用すると、誤情報・偽情報の拡散や意思決定の誤り、社会的・倫理的な問題などにつながる可能性があるため、注意が必要です。

ハルシネーションの原因

生成AIのハルシネーションの原因は複数あり、それらが絡み合って引き起こされると考えられています。代表的な3つの原因は以下のとおりです。

- 1)学習データの問題

- 生成AIは、大量のデータから学習し、そのデータに基づいて文章や画像などを生成します。データに不足や偏り、誤りがあると、生成AIがそれらを学習してしまい、ハルシネーションを起こす可能性が高くなります。

- 2)AIモデルの問題

- AIモデルの構造や学習プロセスの問題も、ハルシネーションの原因の1つです。学習データから実際には存在しない関係性や因果関係を生成してしまうと、事実と異なる回答を導き出す可能性があります。

- 3)文脈の解釈の問題

- 人間が入力したプロンプト(指示・命令文)を生成AIが適切に解釈できない場合も、ハルシネーションを引き起こす原因となります。例えば、文脈によって意味が異なる言葉や暗黙的な表現を使った場合、生成AIが文脈を誤解し、誤った結論や予測を生成する可能性があります。

ハルシネーションへの対策

生成AIを利用する際には、ハルシネーションの可能性を念頭に置いて、以下のような対策を行いましょう。

- 生成AIの回答を鵜呑みにせず、信頼できる情報源と照らし合わせる

- ChatGPTとGemini(旧Bard)など、複数の生成AIを併用する

- 生成AIが適切に解釈できるよう、プロンプトを詳細に入力する

- 医療・法務・ビジネスの意思決定など、情報の信頼性や正確性が求められる分野での利用は慎重にする

生成AIは、ハルシネーションという問題を抱えているものの、大きな可能性を秘めた技術です。企業における利用の場合は社内でAIの利用規定を設けるなど適切な対策を行なって、生成AIを安全・便利に活用しましょう。