AI規制をめぐる、世界各国と日本の動向

| 執筆者: | チーフコンサルタント 大津 卓人 |

| 改訂者: | チーフコンサルタント 大津 卓人 |

人工知能の父であるジョン・マッカーシーによって、「AIとは人間の脳に近い機能を持ったコンピュータープログラム」と定義づけられ半世紀以上が経ちました。現在、AI技術の進化は著しく、AIを使用することは、業務の効率化を図るうえでもはや必須であり、今後はさらなる進化とともに、より需要が高まるのは間違いありません。

一方で、世界においても標準規格の立案は後手に回っており、技術が先行した状態になっています。セキュリティをはじめ、多くの懸念点を払拭するために、AIの標準化はさまざまな国や組織で進められています。本稿では、2023年度開催されたG7広島サミットでの国際指針を皮切りに、各国で加速するAI規制の動き、日本国内の動向、それから各団体におけるAIの標準化や法規制についてまとめていきたいと思います。

AIをめぐる法制度強化に向けた動き

2023年は、生成AIの年といっていいほど、生成AIに関するニュースを目にしない日はありませんでした。注目を浴びることで使用者も増え、現在は皆さんも生成AIを使っていることでしょう。

そんな中、2024年は生成AIに関する法規制やガバナンス強化が進む年になると予想されています。

2023年、広島で開催されたG7サミットにて、生成AIに関する国際的なルールの検討を行うため、「広島AIプロセス」が立ち上がり、10月には「広島AIプロセスに関するG7首脳声明」が発表されました。また、既にEUでは、AIの規制法案が可決されています。米国をはじめとする各国では、独自のAI規制法の整備が進められており、日本政府もAIの研究開発・活用を適正に推進し、イノベーションの促進とリスク対応の両立を図ることを基本理念として「人工知能関連技術の研究開発及び活用の推進に関する法律(AI法)」を2025年6月に公布・施行しました。

法規制以外のガイドラインとしては、NIST(米国国立標準技術研究所)が、AIに関するリスクマネジメントフレームワークを既に公表している他、ISOを運営するISO「International Organization for Standardization」からISO/IEC 42001が発表され、AIに関する認証規格としての対応を進めています。

それぞれの内容や特徴について詳しくみていきましょう。

G7による決定:広島AIプロセス

2023年5月に広島で開催されたG7サミットの結果を踏まえ、その急速な発展と普及を踏まえたAIの国際的なルールづくりをする「広島AIプロセス」が立ち上がりました。G7の首脳は、この広島AIプロセスの成果として12月6日に、生成AI等の高度なAIシステムへの対処を目的とした初の国際的枠組みとして「広島AIプロセス包括的政策枠組み」に合意しました。

「広島AIプロセス包括的政策枠組み」の内容は、「生成AIに関するG7の共通理解に向けたOECDレポート」「全てのAI関係者向け及びAI開発者向け広島プロセス国際指針」「高度なAIシステムを開発する組織向けの広島プロセス国際行動規範」「偽情報対策に資する研究の促進等のプロジェクトベースの協力」の4つになります。なかでも、「全てのAI関係者向け及びAI開発者向け広島プロセス国際指針」では、安全、安心、信頼できるAIの実現に向けて、 AIライフサイクル全体の関係者それぞれが異なる責任を持つという認識の下、12の項目を整理しており、開発者から利用者に至るまでAIに関わる全ての関係者が守るべきルールの原型が先進国を中心にまとまったことになります。そのため、AIを利用する際は、こちらを確認することで安全な使用を促します。

各国・地域の動向

欧州では、2024年3月に世界初となるAIの包括的な規制法案(欧州AI法案)が可決されました。今後は、EU加盟国が5月に正式に承認し、2025年の早期に発行し、26年から適用される見通しです。一部の条項はAI普及のスピード感に合わせてより早く施行される予定です。欧州AI法案はAIの利活用規制を定めた法律であり、EU域内が対象となり、日本企業もEU域内にサービス・商品提供をする場合は対象となりますので注意が必要です(詳細は欧州AI法案)。

米国では2023年10月、バイデン政権が「AIの安心、安全で信頼できる開発と利用に関する大統領令」を発令しました。この大統領令は、米国で初めて法的拘束力のあるAI規制となりましたが、既存サービスは対象外にする方向でEUの取り組みと差別化しています。

しかし、2025年1月にトランプ大統領が就任すると、同日中にこの大統領令は撤回されました。その後、新たにAIに対する規制緩和を指示する大統領令が発令され、AI開発における規制の緩和とイノベーションの促進が強調されました。この新たな方針は、連邦レベルでのAI規制の方向性に大きな転換をもたらしました。

一方、カリフォルニア州では2024年4月に「最先端AIシステムのための安全で安心な技術革新法(SB1047)」の法案が上院司法委員会を通過し、大規模AIモデルの安心かつ安全な開発を推進する法案として注目されました。しかし、2024年9月、州知事がこの法案はAI産業のイノベーションを阻害する可能性があるとして拒否権を行使し、法案は成立しませんでした。

今後、法案の内容によっては日本企業にも影響が考えられるため、動向に注意する必要があります。

日本政府の動向

日本においてもEUや欧米と同様にAI規制に向けた検討が始まっています。G7広島サミットでは、生成AIに関するアジャイル・ガバナンスを提示し、今後AIに関する規制を進める意思を示しました。

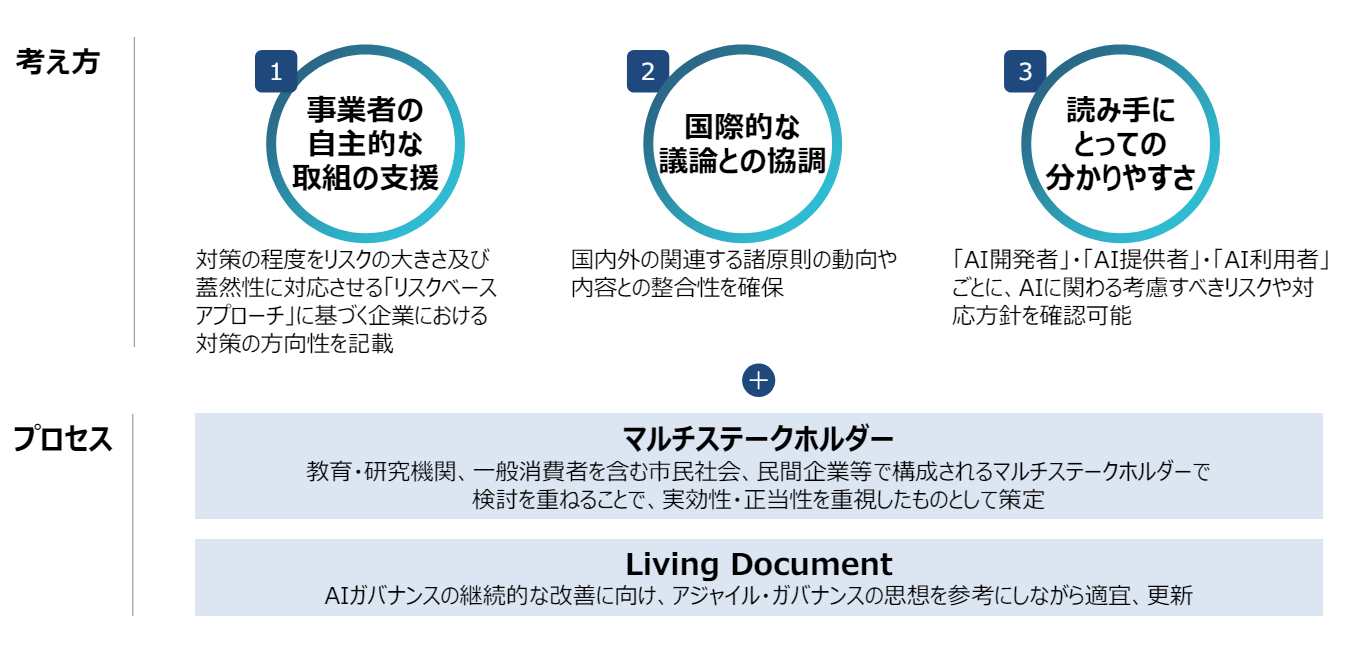

2024年4月には、経済産業省より「AI事業者ガイドライン(第1.0版)」が発表されました。AI事業者ガイドラインは安全・安心なAI活用の促進を狙いとしたAIガバナンスの指針です。このガイドラインは、生成AIの普及を始めとする近年の技術の急激な変化等に対応すべく、従来の3つのガイドラインを統合、改定してとりまとめられました。具体的には、「AI開発ガイドライン(平成29年、総務省)」、「AI利活用ガイドライン(令和元年、総務省)」、「AI原則実践のためのガバナンスガイドラインVer1.1(令和4年、経済産業省)」です。

さらに、2025年3月には「AI事業者ガイドライン(第1.1版)」が公表され、急速に進展するAI技術や国際的な議論の進展に対応するため、アジャイル・ガバナンスの思想を取り入れたリビングドキュメントとして位置づけられました。

このガイドラインは、AIの開発者、提供者、利用者それぞれがリスクベースアプローチに基づき、AIの安全性、公平性、透明性などを確保するための具体的な実践方法を示しています。

NIST(米国国立標準技術研究所)によるフレームワーク

ここまでAIの使用における規制について述べてきましたが、企業は具体的に何をよりどころにしてマネジメントを行うべきなのでしょうか。AI開発組織に対しての答えの1つとなるのが、AIリスクマネジメントフレームワーク(AI RMF)です。AI RMFを作成したのはNISTで、2023年1月に発行されています。AI RMFは、いわゆるネガティブリスクのみならず、ポジティブリスクをも対象としており、前半では、「AIに関わるリスクの考え方」や「信頼できるAIシステムの特徴」、後半では「AIシステムのリスクに対処するための実務」について2部構成で作成されています。 AIシステム開発を進めている、または進めることを考えている組織やAIシステム利用(特に外部向け利用)を考えている組織には、AIリスクマネジメントの実践において非常に有意義なフレームワークとなります。

ISOのマネジメントシステム

NISTと同様にISOでもAIの標準化に向けた取組みが進められています。2025年現在、既に20を超えるAI関連の国際規格が発行されており、さらに30件以上の規格が開発中です。

中でも注目すべきは、AIマネジメントシステムに関する初の国際認証規格「ISO/IEC42001」です。2023年12月に正式に発行されたこの規格は、組織が自らの目的に合わせて効果的・効率的・安全安心にAIシステムを開発・利活用するためのISOマネジメントシステムです。さらに、認証審査機関向けの要求事項を定める「ISO/IEC42006」も2025年中に発行が予定されています。この規格はISO/IEC42001に基づく認証審査を行う機関に対し、必要な能力や審査プロセスの要件を明確にするものです。

ISO/IEC42006の発行に先んじて、ISO/IEC42001への準備を進めることで認証制度が開始した際にすぐに対応できるでしょう。

今後企業がAIサービスを使用するにあたっての勘所

では、企業がAIサービスを使用するには何に着目すればいいのでしょうか。まずは、本コラムで紹介したガイドラインや法律に対して、該当のサービスが適応しているか判断することが必要となってきます。AIに対するガイドラインや法規制は変化の目まぐるしい分野となりますので、これから制定される法規制についても情報収集を行うとともに、その法規制と関連があるガイドライン等についても情報収集を行っていくことが有効でしょう。

また、利用者の守るべきルールについても確認することが必要です。

AIサービスは便利な一方で、情報漏えいや個人情報の侵害の危険性を孕んでいます。そのため、サービスを使用する前にまずはAIサービスの提供する約款と利用規約を確認することが重要です。そのうえで、会社として使用することで考えられるリスクアセスメントを行い、以下の点に気を付けながら社員に対するルールを整備することが求められます。

- 情報漏えい

- 著作権

- 商標権

- 意匠権

- パブリシティー権

AIの使用は業務効率化やイノベーションを促進するうえで、もはや必須と考えられますので、AIがもたらすリスクに留意して、自組織内でルールを定め推進していきましょう。