ChatGPTの公開を契機に、ビジネスに生成AIを活用する環境が加速しています。Googleも同様のサービスをリリースしたほか、各社がChatGPTの機能を生かして開発したサービスを提供し始めています。一方で、生成AIに限らずAI使用における安全性や著作権が問題となり、規制に向けた議論も行われています。日本ではAI規制についてまだ具体的な施策は講じられていませんが、先んじて欧州委員会が2021年4月に欧州連合(EU)「AI(人工知能)規則案」を発表し、2023年6月14日に欧州議会で採択されました(以降、「欧州AI法案」とします)。法案の最終案はこれから作成されますが、施行されればAIの活用を対象とした世界初の法律となります。本稿では、欧州AI法案がどのような法律であり、何を規制しようとしているのかをご説明します。

注目される「欧州AI法案」とは

欧州AI法案を改めて一言で言うと「AI(人工知能)の利活用を規制する世界初の法律 」で、欧州以外の国もこの法案に注目しています。その背景には、Chat GPT等の生成AIの普及にともない、AI利用における著作権に対するリスクやAIを組み込んだ製品の安全性に関するリスクが顕在化したことがあります。例えば生成AIは、サービスによっては入力した情報がAIに学習される可能性があるため情報漏洩などの危険性が指摘されています。

欧州AI法案第2条に定められている適用範囲によると、規制対象となるのはEU内で開発された製品だけでなく、域外企業が提供する輸入製品やAIシステムを利用したサービスも含まれます。つまり、欧州でAIを使ったサービスを展開する日本企業も規制対象になります。

それでは「欧州AI法案」にはどのような特徴があるのでしょうか。

特徴①:リスクベースアプローチ

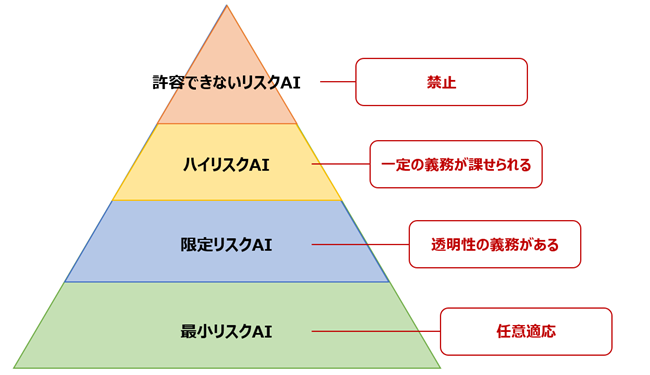

欧州AI法案はリスクに応じて規制内容を変える「リスクベースアプローチ」が取られています。具体的な規制区分としては、「許容できないリスクAI」、「ハイリスクAI」、「限定リスクAI」、「最小リスクAI」の4つがあります。

1.「許容できないリスクAI」区分(第5条)

「許容できないリスクAI」はさらに4つの類型に分けて規制されています。

- サブリミナルな技法を用いて精神的・身体的な害を生じさせるなど、対象者の行動を歪めてしまうような場合

- 年齢・障害などを悪用するなどして精神的・身体的な害を生じさせてしまうような場合

- 人の信用性評価を行い、特定の人や属するグループに不利益をもたらすような場合

- 例外はあるものの、法執行を目的として公の場所でリアルタイムな遠隔生体識別システムを組み込んでいる場合

上記に該当するサービスや製品は原則として禁止されています。4については監視映像の収集や予測捜査へのAI活用も禁止となるようです。

2.「ハイリスクAI」区分(第6条)

主に人権や安全に影響を及ぼす可能性の高いAIを規制しています。ハイリスクAIも2つに分類されます。

- EU法令の対象製品の安全装置としての使用を意図されている場合

- 1以外で人権や安全に影響を与える可能制が高いと判断される場合

1は安全型、2はスタンドアロン型とも言われています。1に該当する場合は事前の第三者適合評価が必要になるので注意が必要です。

ハイリスクAI区分では、プロバイダー(第16条)だけでなくユーザーにも義務(第29条)が課せられます。例えば、プロバイダーには組織内で品質管理システムを確立することや技術文書の作成等が課せられますが、ユーザーには使用説明書に従って運用を行うことや、使用する際には人間が監督し管理を行うこと等が求められます。また、ハイリスクAIに該当する場合は、EU法令の要件を遵守している証明としてCE適合マーク(第19条、第48条、第49条)を付与することを検討するなどサービスや製品の安全性を保証する狙いもあるものとみられます。

3.「限定リスクAI」区分(第52条)

この区分に該当するAIシステムを使用したサービスを提供する場合、プロバイダーはAIが利用されていることをユーザーに知らせる義務が発生します。例えば、チャットボットなどのAIシステムと相互作用しているサービス製品を提供する場合、その旨をユーザーに知らせる義務が発生する、ということです。また、ディープフェイクを使用する場合、提供するコンテンツが人工的に生成されたものであると知らせることや利用した著作権データの詳細開示を行うことなど、安全や人権を守るために透明性を保証する必要があります。

4.「最小リスクAI」区分(第69条)

上記3つのAI区分に該当しないAIシステムについては規制は定められていませんが、本法の主旨に鑑みた行動規範を自主的に適用することを推進しています。

特徴②:罰則

規制に違反した場合、課せられる罰則は2つあります。

まず1つ目は、巨額の制裁金です。「許容できないリスクAI」 に関する規程に反した場合は、4,000万ユーロ(約60億円)か全世界売上高の 7%のうちどちらか高い金額とされ、「ハイリスクAI」に関する規程に反した場合は2,000万ユーロまたは全世界売上高の4%の高い金額とされています。それ以外のリスクAI規程に反した場合はで1,000万ユーロまたは全世界売上高の2%の高い金額とされており、いずれにしても経営に多大なインパクトを与えるのは言うまでもありません。

2つ目は、AIシステムの市場からの取り下げやリコール等の制約措置です(第65条~第68条)。規則に定める要件を満たしていない、または義務の不遵守が発見され、勧告にも関わらず是正措置が講じられなかった場合、制約措置が発動される可能性があります。制約が課されれば、EUでのビジネスが難しくなる可能性があります。

特徴③:イノベーション支援

3つ目の特徴として挙げられるのが政府によるイノベーション支援 です。支援内容としては、大きく2つ挙げられています。1点目は、サンドボックス制度です。AIシステムが市場に公開される前に、開発や試験・検証を促進するための環境を一時的に提供したり、他の目的で適法に収集されたデータを制限付きで利用を認めたりするなど、よりAI開発活動が活発になるよう支援を行う旨の記載があります。2点目は、小規模企業の問い合わせに対して専用のチャネル を設置する支援です。これらの支援によって、よりAI開発やAI利用が活発になると共に安全に利用されるよう支援する姿勢が見受けられます。

今後の動向について

欧州委員会は本法律について2024年後半の施行を検討しています。日本でもG7にて合意した開発企業向けの国際指針と行動規範を開発者と提供者を対象に守らせる措置の検討を始めるなど、規制に関する動きが出てきました。人権だけでなく著作権に関する問題も浮き彫りになっている以上、そう遠くない未来に国内でも法規制に向けて何らかの動きがあると考えられます。いずれにしても「欧州AI法案」が施行されればEU域内にサービス・商品提供をする日本企業も適用対象となるため、最新の動向を注視する必要があるでしょう。