ISO/IEC 42001 情報技術 - 人工知能(AI)-マネジメントシステム‐ガイドライン解説

2022年11月にOpenAIから生成AIが発表されて以来、世界はAIブームの時代に入りました。GoogleのGeminiや、AdobeのFireflyなど新しいAIモデルやサービスが続々と登場しています。これらに負けないAIの開発に自ら着手する企業もあれば、社内業務に全面的に導入する企業、自社製品・サービスに搭載させて新たな製品・サービスを売り出す企業もあります。とはいえ、便利さやチャンスにリスクはつきものです。組織としては、このAIの波に乗りたいところですが、ガバナンスの効かない状態での導入推進は非常に危険です。AIマネジメントシステム規格であるISO/IEC42001の登場は、そうした問題を解決するための一助になるでしょう。既にAIに関するガイドラインは各種公表されていますが、当該規格はISOマネジメントシステム規格ということもあり、相応に洗練されています。この規格の内容を理解しておくことは極めて有益だと考えます。ISO/IEC42001とは誰のための規格なのか、どのような点で優れているのか、採用を検討するべきなのかなど基本的な疑問が解消されるよう、本稿では丁寧かつわかりやすい解説をしていきます。

ISO/IEC 42001とは

ISO/IEC42001は、AIリスクマネジメントの国際規格です。組織が自らの目的に合わせて効果的・効率的・安全安心にAIシステムを開発・利活用するためのISOマネジメントシステム規格で、2023年12月に発行されました。正式名称は、ISO/IEC42001 Information technology — Artificial intelligence — Management system(情報技術 - 人工知能:AI -マネジメントシステム)であり、その種類は「基準・要求事項」です。

なお、ここで言う組織とは、AIシステムを利用する製品やサービスを提供または使用する組織や、AIシステムを開発する組織を指します。基本的には、組織の業種や規模の大小を問わず、あらゆる組織への適用が可能な規格となります。

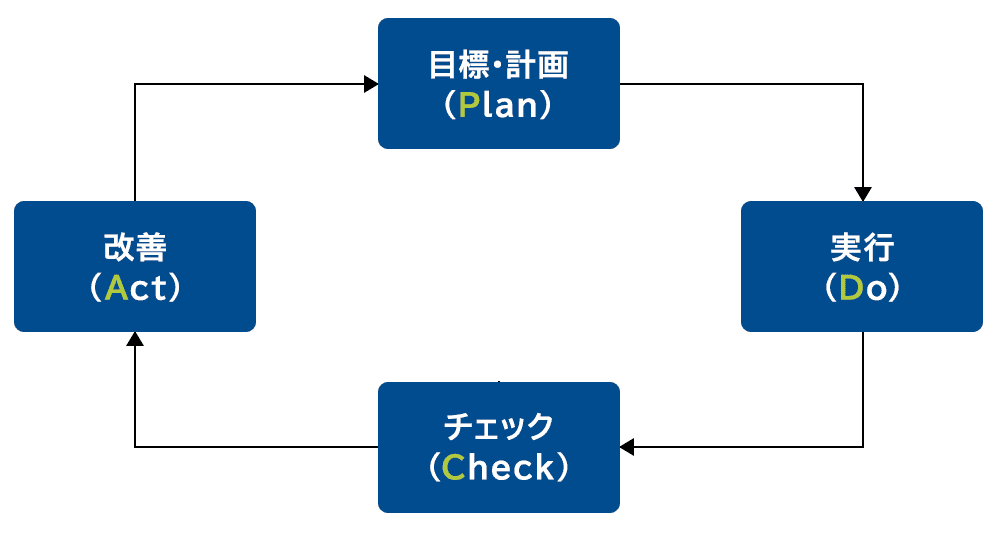

また、基準・要求事項とは「組織がAIの開発・利活用に際して掲げる目的を、PDCAサイクルを回しながら効果的・効率的に達成するために遵守すべき事項」が書かれている規格であるという意味です。ちなみにISOマネジメントシステムにはたくさんの種類があり、例えば顧客満足度の向上を目的とした規格としてISO9001が、情報セキュリティ保護を目的とした規格としてISO/IEC27001などがあります。

ISO/IEC 42001のフレームワークや基本的アプローチ

ISO/IEC42001は、AIのISOマネジメントシステム規格であり、リスクベースアプローチを採用しています。

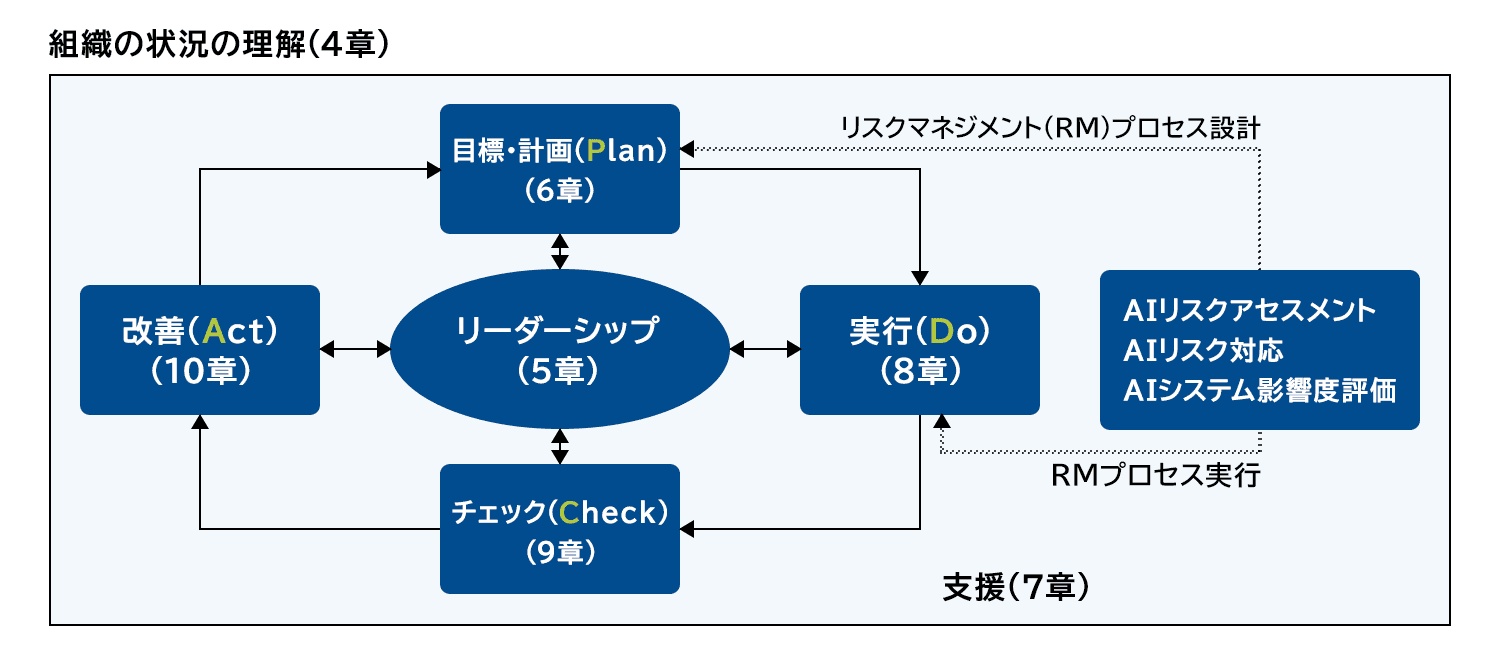

ISOマネジメントシステム規格であるため、フレームワークはPDCAサイクルの考え方に則っています(図1参照)。PDCAサイクルとは、適切な目標および目標達成計画を立案(Plan)し、計画を実行(Do)し、その進捗やパフォーマンスをチェック(Check)し、改善(Act)を図る・・・このサイクルを回し続けることで、より効果的・効率的な活動に昇華させ、最終的に目的を達成させるという考え方です。この考え方を継続的改善と呼び、他のすべてのISOマネジメントシステム規格で採用されているものです。

リスクベースアプローチとは、対象組織に画一的なルールを導入するのではなく、組織が抱えるリスクの大きさに合わせて、導入するルールの種類や規定の厳しさなどを決めるアプローチを言います。例えばAIシステムに自社の機密データを読み込ませる場合は機密情報漏えいリスクを伴うことになりますが、そうでない場合は、そのリスクは小さくなります。また、AIを顧客向け製品に搭載する場合には、ユーザに誤情報を提供し危険に晒してしまう可能性があります。しかし、その製品が社内利用にとどまる場合、リスクは小さくなります。こうしたリスクの有無や大きさを見極めてルール導入の要否やその内容、厳しさを決めるのがリスクベースアプローチです。

ISO/IEC 42001が求めるリスクアセスメントやリスク対応

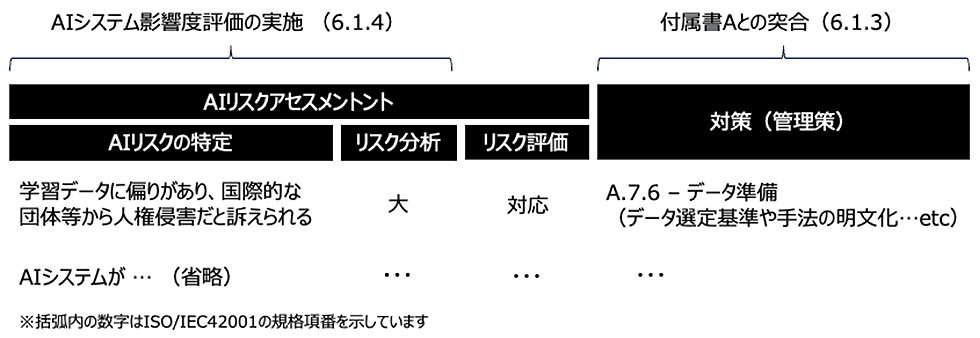

AIのISOマネジメントシステム規格ISO/IEC42001が示すリスクベースアプローチに関する要求事項は、情報セキュリティマネジメントシステム(ISMS)の国際規格であるISO27001のそれに似ています(図2参照)。

具体的には、組織はまず、リスクアセスメントを通じてAIリスクを洗い出し、対応が必要なリスクを選定します。リスク対応では、リスクの大きさに合わせて適切な対策を決めた後に、付属書Aに掲載されているAIリスク対策一覧と突合を行い、選択した管理策の十分性や妥当性を検証することが求められています。リスクベースアプローチなので、何をリスクとして捉え、どのリスクにどういった対策を入れるかを決めるのは組織の裁量に委ねられていますが、対策の品質を一定レベルに保つために設けられた一種のガバナンスと言えるでしょう。

ところで、リスクアセスメントを実施する際には「AIシステム影響度評価」の実施を推奨しています。AIシステム影響度評価とは、AIシステムの開発、提供、または使用から生じる個人や集団、社会への潜在的な影響を評価するプロセスのことです。「個人や集団、社会への潜在的な影響」としているのは、特にAIを使用した製品・サービスを外部向けに提供する場合、自組織に直接的に影響を与えるリスクだけでなく、組織外部の集団や社会などに影響を与えるリスクが大きいためです。

例えば、AIは一歩間違えれば人権侵害に繋がってしまうリスクもあります。学習データの品質自体に偏りがあると、AIが間違った考え方を正しい答えとして、利用者に提供してしまう可能性もあります。実際、ある実験では、画像生成AIに画像の生成を指示したところ多くのケースで「白人」が登場したが、「貧乏」といったワードを含めたところ初めて非白人の画像が生成されたそうです。また、AIサービスが人間の仕事を奪うリスクもあります。中長期的に見れば、人間の仕事をAIが肩代わりしてくれることはいいことでしょうが、それが短期間のうちに起こることで、多くの人の生活を脅かしてしまうことだってあり得ます。実際、米国では2023年にAIに仕事が奪われるとして全米脚本家組合がストライキを起こしたケースもあります。AIにはこうした幅広いリスクが存在するため、個人や集団、社会への潜在的な影響を評価するAIシステム影響度評価を実施することが重要なのです。

ISO/IEC 42001の構成

ISO/IEC42001の構成は、他のISOマネジメントシステムと同じで全10章からなります。このうち、1章から3章は規格の適用範囲や用語と定義など一般的な内容をカバーしています。

AIマネジメントシステムについて要求事項を記載しているのは4章から10章です。4章は、そもそもマネジメントシステムという仕組みを、何を目的として組織のどの範囲に導入するのかを決めるための要求事項が書かれています。5章はリーダーシップですが、ここにはトップマネジメントの役割や責任が記載されています。方針策定もその1つとなっています。こうした前提のもとにPDCAを整備・運用することになりますが、それをカバーしているのが、6章(Plan)、8章(Do)、9章(Check)、10章(Act)です。ISO/IEC42001の特徴とも言えるAIリスクアセスメントやAIシステム影響度評価は、6章と8章で書かれています。6章はPlanなので、これら活動のプロセス設計を求めており、8章はDoなのでそのプロセスの実行を求めているという関係性です。7章は支援です。支援とは文字通りPDCAを支える活動のことです。例えば、AIマネジメントシステムを運用する中で各種決定事項をどこでどのように関係者に周知徹底するのかなどのコミュニケーションルールの整備がここで求められています。また、このPDCAを運用するために必要な関係者の力量管理ルールの整備もここで求められているものの1つです。

巻末に付属書と呼ばれる参考情報があり、同規格には下記4つの付属書が掲載されています。

- 付属書A (規範的) 参照コントロール目標およびコントロール

- 付属書B (規範的) AIコントロールの実装ガイダンス

- 付属書C (情報提供) AI関連の組織目標およびリスク源

- 付属書D (情報提供) ドメインまたはセクター間でのAI管理システムの使用

ISO/IEC 42001が提示する管理策一覧

組織は、AIリスクの大きさに合わせてリスク対応策を決めますが、その際に、付属書Aにある管理策一覧との突合を行い、その十分性や妥当性の検証をすることが求められています。管理策は以下に示す9分類から構成されており、管理策の数は全部で38あります。

【付属書Aに示されている管理策の9つのカテゴリ】

- A.2 AIに関連する方針

- A.3 内部組織

- A.4 AIシステムのためのリソース

- A.5 AIシステムの影響評価

- A.6 AIシステムのライフサイクル

- A.7 AIシステムのためのデータ

- A.8 AIシステムに関心を持つ当事者への情報

- A.9 AIシステムの使用

- A.10 第三者および顧客との関係

出典:ISO/IEC42001:2023, Annex A, Reference control objectives and controlsを元にニュートン・コンサルティングが翻訳・編集

この中でAIリスクならではの管理策をいくつか紹介しましょう。まずは、A.4.4の ツール資源です。ツール資源とはAIシステムのアルゴリズムの種類や最適化手法、評価手法、ソフトウェアやハードウェアなどのことを指し、同管理策は、こうしたものの文書化を求めています。これはAIシステムの開発と運用における透明性を高め、リソースの管理と最適化を助けるために重要だと考えられているためです。

次に、A7.4にAIシステムのデータ品質という管理策があります。これはAI学習に使うデータ品質を担保するための管理策です。AIの性能は学習に使われるデータによるところが大きいため、トレーニングさせる場合には重要な管理策の1つと言えるでしょう。

さらに、A8.3 に外部報告という管理策があります。これはAIシステムが悪影響をもたらす事態に直面した際にしかるべき外部の利害関係者に報告する仕組みの確立を求めた管理策です。組織内部だけでなく組織外部にもたらす影響も小さくないことが想定されるため、このような管理策が設けられています。

付属書Bには、これら管理策一つ一つの具体的な解説が記載されていますので、そちらも非常に参考になるでしょう。

ISO/IEC 42001の使い道

組織の中でAIをちょっとした業務にしか使わないとか、使うにしても組織がそこまで多くない場合は、日本政府の有識者会議「AI戦略会議」が2023年12月に公表し2月19日まで意見公募が実施されていた「AI事業者ガイドライン案」を参考にルール導入を進めることで十分でしょう。また、AIそのものの開発を本格的に目指す場合には、米国の専門機関NISTが発行したAIリスクマネジメントフレームワーク(詳細はこちらをご覧ください)や、英国NCSSが米国CISAなどと発行したGuidelines for secure AI developmentなどを参考にするといいでしょう。

逆に言えば、上記以外のケースではISO/IEC42001が適していると言えるでしょう。当該規格は、AIを本格的に社内展開する場合や、子会社が多く存在するなど管理対象組織が広い場合に、より適しています。なぜなら、当規格はAI事業者ガイドライン案と異なり、AIリスクを管理するための仕組みのあり方を示すものだからです。特にISMSなどISOマネジメントシステムをすでに導入済みの組織においては、慣れ親しんだ考え方に近いので、比較的容易に導入することができます。AIそのものの開発を本格的に目指す場合にはAIリスクマネジメントフレームワークなどを使ったほうがいいと言いましたが、ISO/IEC42001は開発に関する管理策もカバーしているので、もちろん開発を考える組織にも適用することは可能です。

ISO/IEC42001にはもう1つ、他のガイドラインにはないメリットがあります。それはこの規格が「基準・要求事項」であるという点です。すなわち、この規格を組織のAIリスクマネジメントの有効性を監査する際の監査基準として活用することも可能であるということです。現在は認証制度の開始に向けて、認証審査機関向けの要求事項を定めるISO/IEC42006の開発が進んでおり、国際規格原案(DIS)が公開されています。今後、規格発行となればISO9001やISO27001のように認証取得を行うことも可能になり、認証制度の恩恵を受けられる可能性があるかもしれません。

唯一の難点は、まだ英語版しか発行されていないということですが、もし当該規格を使ったルール整備や運用をお考えの企業は、当社ニュートン・コンサルティングが、英語・日本語いずれの言語でも、ご支援することができますので、お声がけください。