AI Risk Management Framework (AIリスクマネジメントフレームワーク、AI RMF 1.0)

近年「AIリスク」が注目されています。「そもそもAI技術はまだまだ発展途上では?リスクがありそうなのはわかるが、まだ議論をするには早いのでは?」と感じる方もいるかもしれません。ですが、AIリスクは既に顕在化しつつあります。たとえば2021年9月、Meta社(旧Facebook社)が整備士やパイロットといった職業の求人広告を出した際、使用したAIシステムが男性ユーザを優先的に選んで広告表示をする仕組みになっていたことが判明、平等法に反していると強く非難されました。とはいえ、まだあまり馴染みのないAIリスクにどう立ち向かえばいいのか?その悩みに答えるべく、発行されたのがArtificial Intelligence Risk Management Framework(AIリスクマネジメントフレームワーク)、通称AI RMFです。

AI RMFとは?

AI RMFを作成したのはNIST(米国国立標準技術研究所)※で、2023年1月26日に発行されたばかりです。本文は英語で50ページ近くあるため、気軽に読み解けるものではありませんが、近年のAIリスク顕在化を踏まえると注目に値します。AIリスクマネジメントは、一般的なリスクマネジメントプロセスと何が同じで何が異なるのでしょうか。

※NIST:米国の連邦政府機関に対するセキュリティ管理策を定めたガイドラインなどを発行している機関。National Institute of Standards and Technology の略称

リスクの定義

先に「同じ部分」について述べておきます。リスクの定義と、リスクマネジメントの建て付け、この2点については、AIリスクマネジメントと言えど、ほぼ一緒です。AI RMFが想定する「リスク」は、いわゆるネガティブリスクのみならず、ポジティブリスクをも対象としています。具体的には次のように定義しています。これは、リスクマネジメントの国際規格であるISO31000※が用いる「リスク」の意味とほぼ同じです。

「リスクとは、ある事象の発生確率と、その事象がもたらす結果の大きさまたは程度を複合的に測定したものである」(出典:NIST AI 100-1 Part I: Foundational Information)

※ISO31000が想定する「リスク」は「目的に対する不確かさの影響」です。これは、リスクマネジメントに関する用語をひとまとめにして解説した国際規格「Guide73 - リスクマネジメント- 用語」にて定義されているものです

リスクマネジメントの建て付け

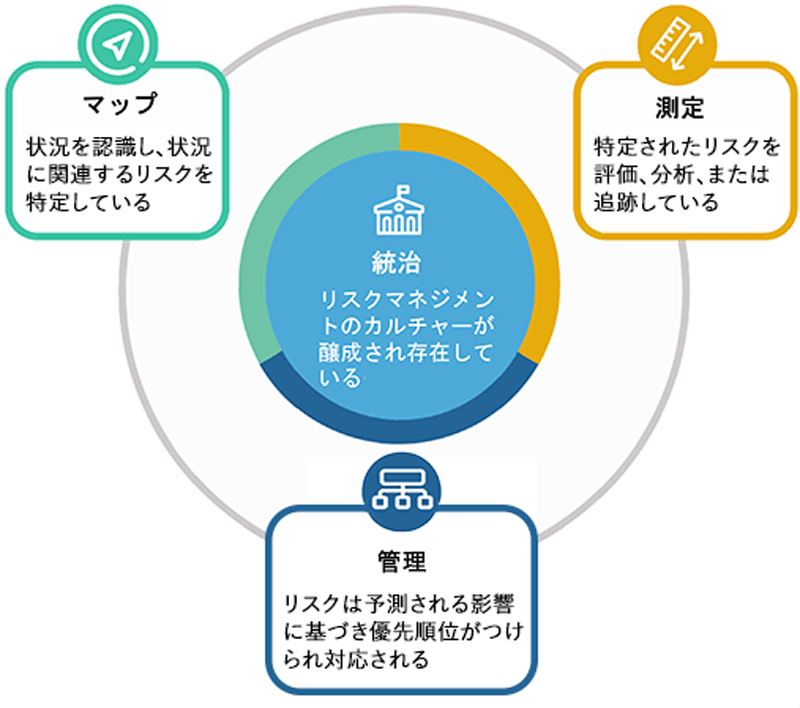

次に「リスクマネジメントの建て付け」についてです。一般的にリスクマネジメントの建て付けは「枠組」と「プロセス」からなります。「枠組」とは「方針や役割・体制等」、「プロセス」は字義通りリスクマネジメントのプロセスを意味します。AI RMFでもこれらの考え方を取り込んでいます。「リスクマネジメント方針」や「役割・体制」「力量」といった「枠組」的な要素も登場しますし、「前提条件の明確化※」「リスクアセスメント」「リスク対応」「モニタリング及びレビュー」といった「プロセス」的な要素も登場します。ちなみにAI RMFでは、「枠組」のことを「統治」と呼んでいます。また、前提条件の明確化やリスク特定のことを「マップ」と呼び、リスク分析を「測定」、リスク評価とリスク対応を「管理」と呼んでいます(図1参照)。

※ISO31000では「適用範囲、組織の状況及び基準」と表現されているものです

AI RMFは一般的なリスクマネジメントと何が違うのか?

では、逆に一般的なリスクマネジメントと異なる点はなんでしょうか。異なる点というよりも、特徴的な点といった方が正しいかもしれません。細かい部分では特徴的な点がいくつもありますが、大きくは下記2点です。

- 前提条件の明確化にあたって「ライフサイクル」の観点を取り入れている点

- AIリスクを考えるにあたって「信頼性(Trustworthiness)」の観点を取り入れている点

「ライフサイクル」の観点

「ライフサイクル」とは、AIシステムのライフサイクルのことです。具体的には、「計画と設計」「データの収集と処理」「AIモデルの構築と利用」「検証と立証」「展開と利用」「運用と監視」という一連のサイクルを指します。なぜ、AIリスクになると「ライフサイクル」の観点が重要なのでしょうか?それは、ライフサイクルの段階に応じて、意識すべき目的や関与する人が異なるからです。たとえば「データの収集と処理」の段階では、プライバシー保護に関するリスクに目が向きがちですが、「AIモデルの構築と利用」の段階では、AIモデルが意図しない差別や偏見を生まないか、気になることもあるでしょう。

「信頼性(Trustworthiness)」の観点

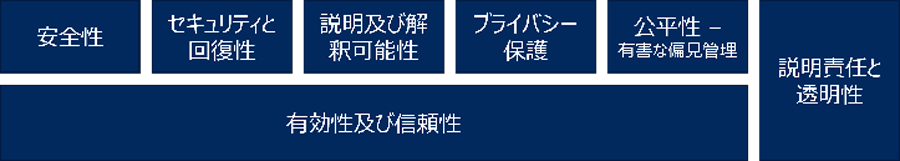

「信頼性(Trustworthiness)」は、AIリスクを考える上で1つの起点になるものです。リスクマネジメントの目的は、企業であれば、売上やコンプライアンス、業務の効率性・有効性の向上などが一般的ですが、AIシステムでは「信頼性」の担保が大きな目的になるわけです。なお、「信頼性」は以下の7要素から構成されます。

- 有効性及び信頼性

- それぞれについて簡単に説明しておきます。まず「有効性及び信頼性」における「有効性」とは、AIシステムに求められる要件が満たされており、かつ、それを客観的に証明できる状態になっていることを言います。「信頼性」とは与えられた条件下で、与えられた時間感覚で、故障することなく、要求された通りに動作することを意味します。

- 安全性

- 誰にとっての「安全性」なのかといえば、人間にとっての安全性です。人間の生命、健康、財産、環境が危険に晒される状態にならないようにすることを求めたものです。

- セキュリティと回復性

- 「セキュリティと回復性」の「セキュリティ」は、不正アクセスや外部からの攻撃に耐えられる状態を目指すことです。「回復性」は、予期せぬ事態に直面しても、重要な機能を維持できるか、または安全に停止するような機能を指します。

- 説明責任と透明性

- 「透明性」を担保することが「説明責任」を果たすことにつながります。透明性とは、AIに関わる人たちが、AIのライフサイクルに応じた適切なレベルの情報へのアクセスを提供できるようになっているかどうかを示すものです。

- 説明及び解釈可能性

- 「説明可能性」とは、AIシステムの動作の根底にあるメカニズムを言語化できる状態になっていることです。また、「解釈可能性」とは、AIシステムが出したアウトプットが解釈可能なものになっていることを指します。

- プライバシー保護

- 「プライバシー保護」は、文字通りプライバシーの保護です。たとえば、AIシステムが推論などによって個人を特定してしまうといったリスクをコントロールすることを求めたものです。

- 公平性

- 「公平性」は、有害な偏見や差別といった問題が起きないよう、平等性や公平性に配慮することを意味します。

AI RMFはどんな構成になっているのか?

AI RMFは、大きくパート1とパート2から構成されています。

パート1は、フレームワークの基本的な考え方について言及する章です。具体的にはたとえば、先述したような基本的な用語の定義やAIシステムの信頼性などについて解説しています。この「信頼性」の視点は、リスクを考える大事な観点を提供してくれるという点で非常に有益だと言えるでしょう。

パート2は、「リスクマネジメントプロセス及び要求事項」を記載しています。要求事項とは、AIリスクマネジメントを実践する組織が守るべきルールのことです。ここで前段の【図1】でご紹介した「統治」「マップ」「測定」「管理」の図が登場します。この図のことを、「AI RMF Core」と呼んでいます。これらの中でも「マップ」の部分は一際、有益であると言えそうです。なぜなら、一般的には馴染みの薄いAIリスクを洗い出す上での重要なプロセスになるからです。AIリスクを考えるにあたっては「ライフサイクル」やそこに関係する様々なステークホルダーをはじめ、幅広い視点で、組織を取り巻く状況の理解を進める必要があります。その視点を、何もないところから組織や個人が考え出すのは骨の折れることですので、サポートしてくれる「マップ」はありがたい情報源です。

AI RMFは誰がどう使うべきか?

AI RMFは、以下の組織に有益だと言えます。

- AIシステム開発を進めている、または進めることを考えている組織

- AIシステム利用(特に外部向け利用)を考えている組織

本格的なAIリスクマネジメントを実践されたい方は、AI RMFをしっかりと読み込んで、この建て付けに沿って実践してみるのも良いでしょう。もう少し軽めに、ヒントをもらいながら軽めのリスクアセスメントをしたい方は、パート1の「信頼性」やパート2の「マップ」の箇所を少し読んで、使えそうなところを使ってみるのが良いでしょう。

ところで、AI RMFには、リスクマネジメントをどのように実践するにしても、「確かに、ここは注意した方がいいだろうな」と気づかせてくれる点があります。それは次の箇所です。

AIのリスクは、個別に考えるべきではありません。AIの関係者は、ライフサイクルにおけるそれぞれの役割に応じて、異なる責任と認識を有しています。例えば、AIシステムを開発している組織は、そのシステムがどのように使用される可能性があるかについての情報を持っていないことが多いのです。AIリスクマネジメントは、より広範な企業のリスクマネジメント戦略およびプロセスに統合され、組み込まれる必要があります。AIリスクをサイバーセキュリティやプライバシーなどの他の重要なリスクと一緒に扱うことで、より統合された結果と効率性を得ることができます。

※出典:1.2.4 Organizational Integration and Management of Risk from NIST AI 100-1を元に筆者が翻訳

言い換えれば、「AIリスクマネジメントを部署別・機能別にバラバラにやってるだけでは重要なAIリスクを見落としてしまう可能性がある」ということです。関係者を巻き込んでワークショップをするなど、より組織の壁を超えたリスクマネジメントが必要だということです。同じ理由から、全社的リスクマネジメント(ERM)やサイバーリスクマネジメントとの統合も重要だと言えるでしょう。こうしたことを何も参考にせず闇雲に進めるよりも、AI RMFを参考にしながら実践した方が、はるかに効率性・有効性が高まるのではないでしょうか。

※2024年7月4日にAIセーフティ・インスティテュート (AISI)から日本語翻訳版がリリースされました。