EU AI法と企業に求められる対応とは

2025年2月、EU AI法の一部が正式に適用開始となり、2027年8月までに主要義務が段階的に適用されます。

でも、これって「うちには関係ない」と思っていませんか?

このまま気にせず放置していて、本当に大丈夫でしょうか?

結論から言えば、EU AI法は「海外の話」ではありません。たとえ御社がEU域内で事業をしていなくても、AIのグローバル化と規制の波は、確実に日本企業のリスクマネジメントや製品・サービス設計に影響してきます。実際、G7(主要7カ国)やOECD(経済協力開発機構)、そして日本政府の「AI事業者ガイドライン」も、EU AI法の方向性と整合性を持って動いています。

というわけで、本記事では、EU AI法の全体像をわずか10分で理解できるように、ポイントをかいつまんでご紹介します。具体的にはこの記事をお読みいただくことで以下の疑問が解決できます。

- EU AI法って結局、何を規制しようとしているの?

- 自社は「対象」になるの?ならないの?

- 高リスクAIって何?該当すると何が必要なの?

- ISO/IEC 42001って関係あるの?

- 「今、何をすべきか」をどう判断すればいい?

他部署や経営層への共有にも活用できる「実務向けの要約資料」として、ぜひご活用ください。

EU AI法の概要

EU AI法は、「どのような企業が対象となるのか」「いつから施行され、どのような罰則や報告義務が課されるのか」といった基本事項を理解することが対応の第一歩です。特にAIシステムを提供・使用する企業にとっては、自社が法の対象となるかどうかの判断と、該当する場合に備えるべき対応内容を整理しておくことが重要です。以下の表に、EU AI法の概要を実務的な視点で整理しました。なお、EU AI法の正式な名称は「Regulation (EU) 2024/1689 laying down harmonised rules on artificial intelligence」で、「Artificial Intelligence Act」(AI法)は通称名です。世界初のAIに関する包括的な法的枠組みとして制定されました。

表1 EU AI法の基本事項:対象範囲・義務・罰則・関連ガイドラインの概要

| 項目 | 内容 |

|---|---|

| 適用対象者 | EU域内でAIシステムを提供・使用するすべての者。域外でもEUで使われる可能性のあるAIシステムは対象 |

| 施行日 | 2024年8月1日施行。AIシステムの持つリスクの大きさに合わせて、6~36カ月の適用猶予あり |

| 報告義務 |

|

| 罰則 |

|

| 関連法規・ガイドライン |

|

| 企業に求められること | 自社AIシステムのリスク分類(禁止/高リスク/一般等)を評価し、分類に応じた義務(QMS、適合性評価、情報公開など)に対応すること |

出典:EU AI法および欧州委員会が公表した関連ガイドラインに基づきニュートン・コンサルティングが作成

EU AI法の施行日については上表にて「2024年8月1日施行。AIシステムの持つリスクの大きさに合わせて、6~36カ月の適用猶予あり」と書きましたが、基本的にはより大きなリスクを持つAIシステムから順番に法規制の適用が進む仕組みになっています。リスク区分の詳細については後述しますが、現時点で公表されている適用スケジュールは以下のとおりです。許容できないリスク(禁止AI)から順に規制が始まり、最終的にはあらゆるリスクレベルのAIに関連する義務が順次適用されます。

表2 EU AI法における段階的な適用スケジュール

| 適用開始時期 | 内容 |

|---|---|

| 施行後6カ月 (2025年8月) |

許容できないリスク(禁止AI)の使用禁止が適用開始(例:社会的スコアリング、感情推測の一部など) |

| 施行後12カ月 (2025年2月) |

汎用目的AI(GPAI)モデルに関する義務が適用 ※施行日以前に市場に出されたモデルはさらに24か月猶予あり |

| 施行後24カ月 (2026年8月) |

高リスクAIシステムへの義務が適用開始(QMS、適合性評価、リスク管理等) |

| 施行後36カ月 (2027年8月) |

製品に組み込まれる高リスクAI等への義務が適用開始(例:医療機器、自動運転車等への組込型AI) |

出典:欧州委員会の発表情報をもとにニュートン・コンサルティングが作成

なお、汎用目的AI(GPAI)モデルとは、特定の用途に限定されず、さまざまな目的に利用可能なAIモデルを指します。ChatGPTなどの生成AIが典型例であり、EU AI法ではこうしたモデルの提供者にも透明性や安全性に関する義務が新たに課されています。

具体的な対象者と要求事項

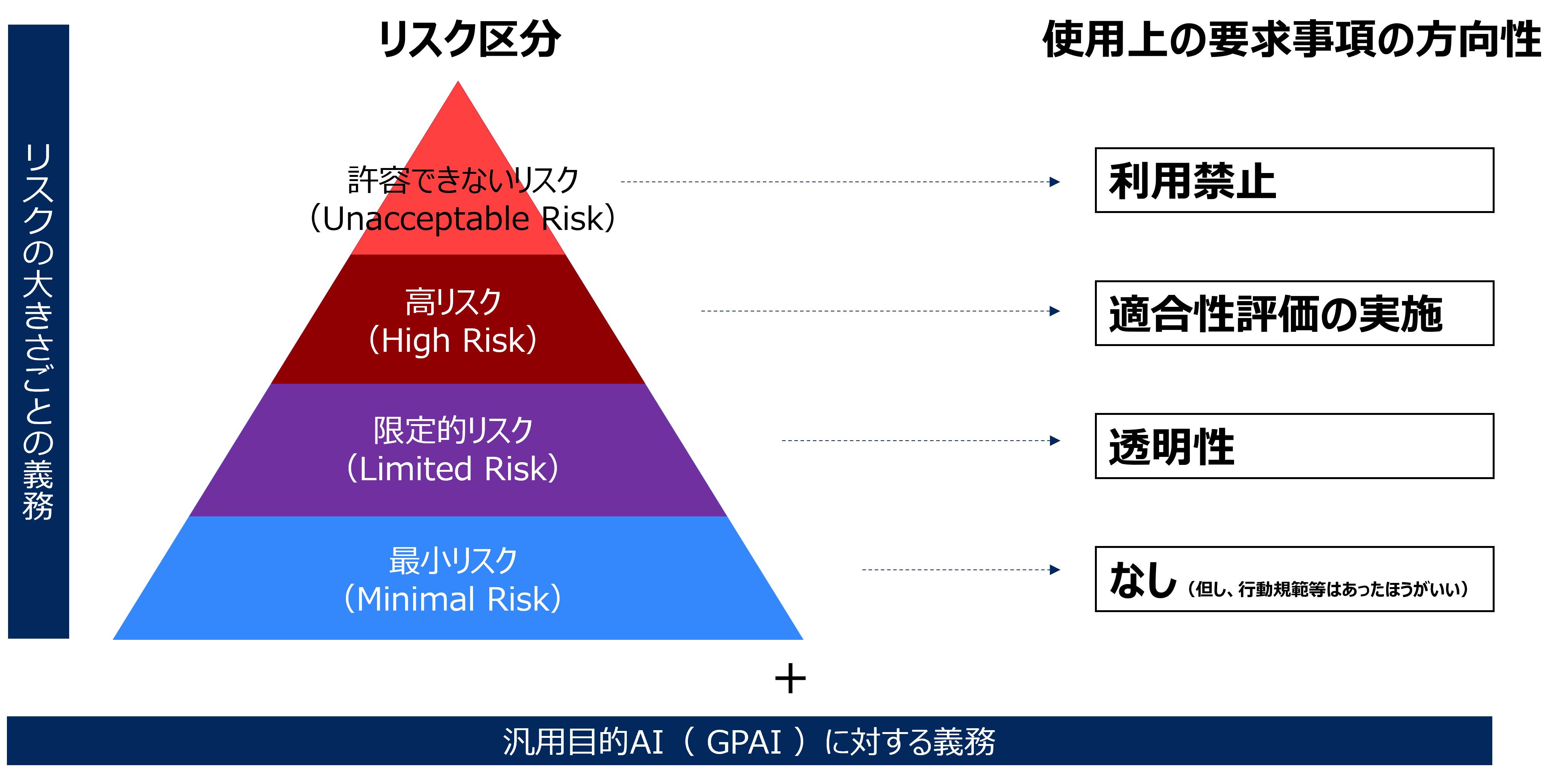

EU AI法は、AI技術をリスクの大きさに応じて分類し、それぞれに異なる義務(=要求事項)を課す「リスクベースアプローチ」によって構成されています。なお、「リスクベースアプローチ」とは、AIの活用に伴うリスクの「深刻さ」と「発生可能性」を事前に評価し、それに応じた対策レベルを定める考え方です。

リスクが高いAIには厳しい義務が課され、リスクが小さいAIには柔軟な対応が許されます。これにより、過剰な規制によってイノベーションが阻害されることなく、社会的なリスクには的確に対応できる制度設計となっています。

以下の図は、EU AI法におけるリスク区分と、それぞれに求められる義務の概要です。

図 EU AI法におけるリスク区分と、それぞれに求められる義務の概要

なお、EU AI法は、その全体構成自体が「リスクに応じた規制強度」という考え方に基づいて設計されています。下表の通り、リスクレベルが高くなるほど要求事項が重くなり、それが章構成にもそのまま反映されているのが特徴です。

表3 EU AI法の章構成

| Chapter | 概要 |

|---|---|

| 第1章 | 一般条項(目的、定義、適用範囲など) |

| 第2章 | 禁止されるAIの利用(例:社会的スコアリング、感情推測) |

| 第3章 | 高リスクAIシステムの要件(リスク管理、適合性評価、QMSなど) |

| 第4章 | 透明性義務(例:チャットボットの開示、ディープフェイクの明示) |

| 第5章 | 汎用目的AI(GPAI)モデルへの義務(Article 53–55) |

| 第6章以降 | 規制当局、監督体制、罰則、附則など |

出典:EUの官報(EUR-Lex)をもとにニュートン・コンサルティングが作成

さて、各リスク区分に当てはまるAIシステムがどんなもので、どんな対応がおおよそ求められているかを簡単に解説していきます。

- 【許容できないリスク(禁止AI)】

- この区分に該当するAIシステムは、いかなる目的でも使用が認められていません。たとえば、個人を社会的に評価・格付けする「社会的スコアリング」や、本人の同意なく感情を読み取る「感情推測」、特定の属性に基づいて人を分類・差別するようなAIシステムなどがこれに該当します。これらは、基本的人権や民主主義の根幹を脅かすものとして、開発・提供・使用すべてが法的に禁止されています。

- 【高リスクAI】

- 社会的影響が大きい用途で使用されるAIシステムは「高リスク」に区分され、使用が認められる区分の中では最も多くの義務が課されます。具体的には、雇用・教育・法執行・重要インフラなど、意思決定の影響が重大な領域で利用されるAIシステムです。こうしたAIシステムを提供する企業は、リスク管理体制の整備、品質マネジメント(QMS)、人的監督の確保、適合性評価など、多層的な対応が求められます。また、AIシステムを利用する企業側も、用途や運用上の義務が発生するため、提供者・利用者の両方が対象になります。

- 【限定的リスクAI】

- この区分は、主にユーザーへの影響は限定的ではあるものの誤解や誤用のリスクがあるAIシステムを対象としています。たとえば、チャットボットやディープフェイク生成ツールなど(例:Open AI Sora, Google Gemini, Adobe Fireflyなど)が該当します。これらは、ユーザーが「人間と話している」と誤認したり、「本物の映像」と誤解したりする可能性があるため、AIであることを明示する透明性義務が課されます。提供者もしくは利用者は、エンドユーザーに対して適切な説明や表示を行う責任を持ちます。

- 【最小リスクAI】

- AI翻訳ツール、スパムフィルター、レコメンドエンジンなど、日常的に使われているAIの多くはこのカテゴリに該当します。リスクが低いため、EU AI法上の義務は原則として課されません。ただし、事業者としては今後の規制動向を踏まえ、ISO/IEC 42001などのAIガバナンス規格や各種ガイドラインに基づいた自主的対応を進めておくことが望ましいとされています。

- 【GPAIモデル】

- 汎用目的AI(GPAI)モデルとは、特定の用途に限定されず、さまざまな目的に活用できるAIを指します。代表例としては、ChatGPTのような大規模言語モデルや、マルチモーダルAIが該当します。こうしたモデルは、リスク区分のどれか1つに当てはまるというよりも、その汎用性ゆえに横断的なリスクを生む可能性があるとされ、EU AI法では別途、専用の義務を定めています。たとえば、著作権の保護、透明性の確保、重大インシデントの報告義務などが含まれます。

高リスクAIに該当する組織の定義と求められる要件

EU AI法の中で最も企業にインパクトを与えるのが、「高リスクAI」に関する規定です。この区分に該当するAIシステムを扱う事業者は、最も重い義務を負うことになりますので、ここでもう少し掘り下げて解説しておきます。

高リスクAIの対象となるのは、どのような組織か

高リスクAIとは、社会的・個人的に重大な影響を及ぼす可能性があるAIシステムを指します。該当するかどうかは、「何に使われるか(用途ベース)」と「何に組み込まれるか(製品ベース)」のいずれかで判断されます。

まず、用途ベースを見てみましょう。以下の分野でAIシステムを利用している場合、そのAIシステムは高リスクAIに該当する可能性が高いとされます。

- 自然人のバイオメトリック識別および分類(例:顔認証、指紋認証)

- 重要インフラの管理・運用(例:電力、水道、交通制御)

- 教育・職業訓練(例:自動試験評価、適性判定)

- 雇用・労働者管理・自営業へのアクセス(例:採用支援、パフォーマンス分析)

- 不可欠な民間・公共サービスへのアクセス判断(例:社会保障の可否判断、住宅ローン審査)

- 法執行(例:犯罪予測、容疑者のリスク評価)

- 移民、庇護、国境管理(例:入国審査における虚偽検知)

- 司法および民主的プロセスの運営(例:裁判の判断支援、選挙システム)

次に、「製品ベース」です。EUにはすでに、医療機器、自動車、昇降機など多くのCEマーク(※EUの安全基準に適合した製品に付される表示)対象製品に関する安全規制があります。これらの既存の規制製品にAIシステムが搭載されている場合、そしてそのAIシステムが製品の安全性・機能性に重要な影響を及ぼす中核技術とされる場合には、EU AI法上でも高リスクAIとして扱われます。

このような分類の判断は、条文の読み込みだけでは難しいケースも多いため、欧州委員会や民間事業者が提供する「EU AI法コンプライアンス・チェッカー」などのツールを活用して、初期的な自己診断を行うのも有効です。これにより、自社のAIプロジェクトが高リスクに該当する可能性を事前に把握し、対応の優先度を明確にすることができます。

高リスクAIを扱う組織に求められる義務

対象組織は、EU AI法 第9条~15条で定められた技術的・組織的な要件をすべて満たす必要があります。主な内容は以下の通りです。

- リスクマネジメント体制の整備(第9条)

- 高品質で偏りのない訓練・検証用データの確保(第10条)

- 技術文書の作成と更新(第11条)

- 記録保持(ログ管理)体制の構築(第12条)

- 透明性の確保と使用説明(第13条)

- 人的監督の確保(第14条)

- 精度・堅牢性・サイバーセキュリティ対策(第15条)

さらに、これらを体系的に実現する品質マネジメントシステムの整備・運用(第17条)も求められています。この辺りは、QMS(ISO 9001)やISMS(ISO/IEC 27001)、AIマネジメントシステム(ISO/IEC 42001)などとの整合を図ることで整備・運用が進めやすくなる可能性があるといえるでしょう。

最後に、重要なのが、第三者による「適合性評価(Conformity Assessment)」の受審です。これは、「自社の高リスクAIがEU AI法の要件に適合しているか」を正式に証明するプロセスであり、多くの場合、外部の認証機関による審査が必要になります。これによって審査に合格すると認証マークを製品に貼付できるようになり、それで晴れて、EU AI法の高リスクAIとしての要件を満たしたことになります。

ISO 9001やISO/IEC 42001などの活用方法

EU AI法では、AI事業者に対して明示的に「この規格を使いなさい」とは指定していません。つまり、ISO 9001やISO/IEC 27001、ISO/IEC 42001の取得は義務ではありません。

しかし、高リスクAIに求められる要件(第9~15条)を体系的かつ実務的に満たしていく上で、これらの国際規格は極めて有効なツールです。特に、ISO/IEC 42001は、EU AI法の立法動向を踏まえて策定されたAIマネジメントシステム(AIMS)の国際規格であり、その親和性は高いといえます。ISO/IEC 42001の詳しい解説記事は、こちら(ISO/IEC 42001 情報技術 - 人工知能(AI)-マネジメントシステム‐ガイドライン解説)をご覧いただければと思いますが、EU AI法の求めに対してどのようにカバーしているかを以下に解説しておきます。

表4 EU AI法の高リスクAI要求事項とISO/IEC 42001による対応マッピング(参考)

| EU AI法の高リスクAIの要求事項 | 対応できるISO規格の要素の例 |

|---|---|

| リスクマネジメント体制の整備(第9条) | ISO/IEC 42001:

|

| 高品質で偏りのない訓練・検証用データの確保(第10条) | ISO/IEC 42001:

|

| 技術文書の作成と更新(第11条) | ISO/IEC 42001・ISO 9001共通:

|

| 記録保持(ログ管理)体制の構築(第12条) | ISO/IEC 42001:

|

| 透明性の確保と使用説明(第13条) | ISO/IEC 42001:

|

| 人的監督の確保(第14条) | ISO/IEC 42001:

|

| 精度・堅牢性・サイバーセキュリティ対策(第15条) | ISO/IEC 42001:

|

出典:EU AI法の第9~15条に記載された要求事項と、ISO/IEC 42001:2023(Artificial Intelligence Management System)の構成要素との対応関係を参考としてニュートン・コンサルティングが整理、作成

組織に求められていること

EU AI法への対応において、まず企業が最初に行うべきは、自社が本法の適用対象となるかどうかの早急な評価です。対象となるか否かによって、求められる義務の範囲も、準備すべき体制も、整備のスケジュール(線表)も大きく異なります。特に、高リスクAIに該当するAIシステムを提供・利用している場合は、リスク管理、人的監督、技術文書、ログ管理、品質マネジメントシステム(QMS)の構築、そして適合性評価の実施といった複雑かつ多岐にわたる対応が求められるため、今すぐの準備が不可欠です。

仮にEU AI法の直接の適用対象外だと判断されたとしても、それで終わりにするべきではありません。むしろ今後の備えとして、EU AI法の内容を深く理解し、社内におけるAIガバナンス体制を整備しておくことが極めて重要です。その理由は明快です。EU AI法に記載されている要求事項は、「透明性」「人的監督」「リスク管理」「差別防止」など、人と組織の安心・安全を守るための極めて常識的で普遍的な価値観に基づいているからです。

AIガバナンスを整備する際には、プロジェクト体制の立ち上げや、採用するフレームワークの検討、社内外ステークホルダーのニーズ・懸念事項の洗い出しを行い、AIリスク管理プロセスやルールを設計・文書化していくといった基本ステップが有効です。そのうえで、関係者への周知や教育、モニタリング体制の設計も含め、継続的に改善・運用される仕組みとして根付かせることが求められます。

さらに注意すべきは、EU AI法を取り巻く状況では今後も、実務指針や適用ガイドライン、実践規範などが次々に発行される可能性があるということです。こうした情報に常にキャッチアップし、自社にとっての影響を迅速に評価・対応できる体制も併せて整えておくべきでしょう。

EU AI法を単なる規制への対応義務と捉えるのではなく、信頼性あるAI活用のガイドラインとして捉え、先んじて動くことが、社会的信頼と競争優位性を築く鍵になるはずです。